La propuesta de demanda colectiva de varios propietarios de Tesla contra la firma californiana por publicidad engañosa del Autopilot FSD (Full Self-Driving) ha quedado en la nada: un juez de distrito en Oakland (California) ha determinado que tendrán que presentar reclamaciones en arbitraje individual y no ante un tribunal.

El fallo es una victoria para Tesla, que se libra de tener que afrontar demandas colectivas por esta tecnología que, siete años después, sigue sin ofrecer la prometida conducción autónoma total.

Al aceptar los términos y condiciones tendrán que reclamar individualmente

Fue en octubre de 2016 cuando Elon Musk, durante la presentación del Autopilot FSD señaló que sería un sistema de nivel 5: el máximo de los que categorizan las tecnologías de conducción automatizadas. En aquella cita reconoció que tardaría en llegar, por validación de software y de homologación, pero afirmó que lo haría. Y lo reiteró en este vídeo promocional que fue falseado.

A lo largo de estos siete años el FSD ha ido sumando mejoras y nuevas funciones para circular en piloto automático tanto por autovía y autopista como por ciudad. Pero aún sigue siendo un nivel 2, obligando a mantener en todo momento la atención en la carretera y las manos en el volante.

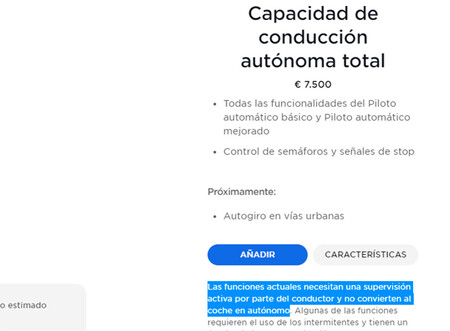

Aviso en el configurador de Tesla del Autopilot FSD.

Aviso en el configurador de Tesla del Autopilot FSD.

Es precisamente lo que criticaban estos cuatro clientes que querían presentar una demanda colectiva contra Tesla: que la marca reiteró en repetidas ocasiones que se trataba un sistema de conducción autónoma total (de hecho ese es el nombre del sistema) y que pagaron miles de dólares por esta tecnología cuyas capacidades siguen sin cumplir con lo prometido.

Es más argumentaban que no sólo no ha cumplido, sino que este sistema no es del todo fiable y que ha provocado accidentes, lesiones y hasta fallecidos. Lo que es cierto: desde 2016 la Administración Nacional de Seguridad en el Transporte por Carretera (NHTSA) ha abierto más de tres docenas de investigaciones especiales de accidentes de Tesla con esta tecnología activada. Y se han registrado 23 muertes hasta la fecha.

Además, el sistema tiene problemas para detectar los vehículos de emergencia parados (en uno de los incidentes hasta cinco agentes de policía resultaron heridos), habitualmente le hemos visto confundir señales y semáforos (llegó a confundir el sol con un semáforo o un STOP con un cartel de Burger King) y hasta a provocado accidentes en cadena.

Tesla niega su responsabilidad en los accidentes mortales del FSD. La resolución del juez californiano llega en paralelo al primer juicio contra Tesla por la muerte de un conductor con el Autopilot FSD en la ecuación: circulaba con este sistema activado y chocó a 105 km/h contra una palmera, resultando el coche incendiado.

Tesla defiende que el accidente se debió a un error del conductor y no de su tecnología. Algo habitual en la firma de Palo Alto. Lo ha hecho en repetidas ocasiones, incluyendo el accidente en cadena en un túnel con el FSD de protagonista. Incluso ha echado balones fuera cuando a un Model Y se le llegó a caer el volante, sin admitir que se trataba de un defecto de fábrica.

A principios de este 2023, el Autopilot FSD fue objeto de una nueva llamada a revisión en EE.UU. La NHTSA determinó que más de 360.000 coches debían actualizar el software del FSD porque no cumplía con las leyes de seguridad vial y podía causar accidentes.

Ver 3 comentarios